Información actualizada disponible

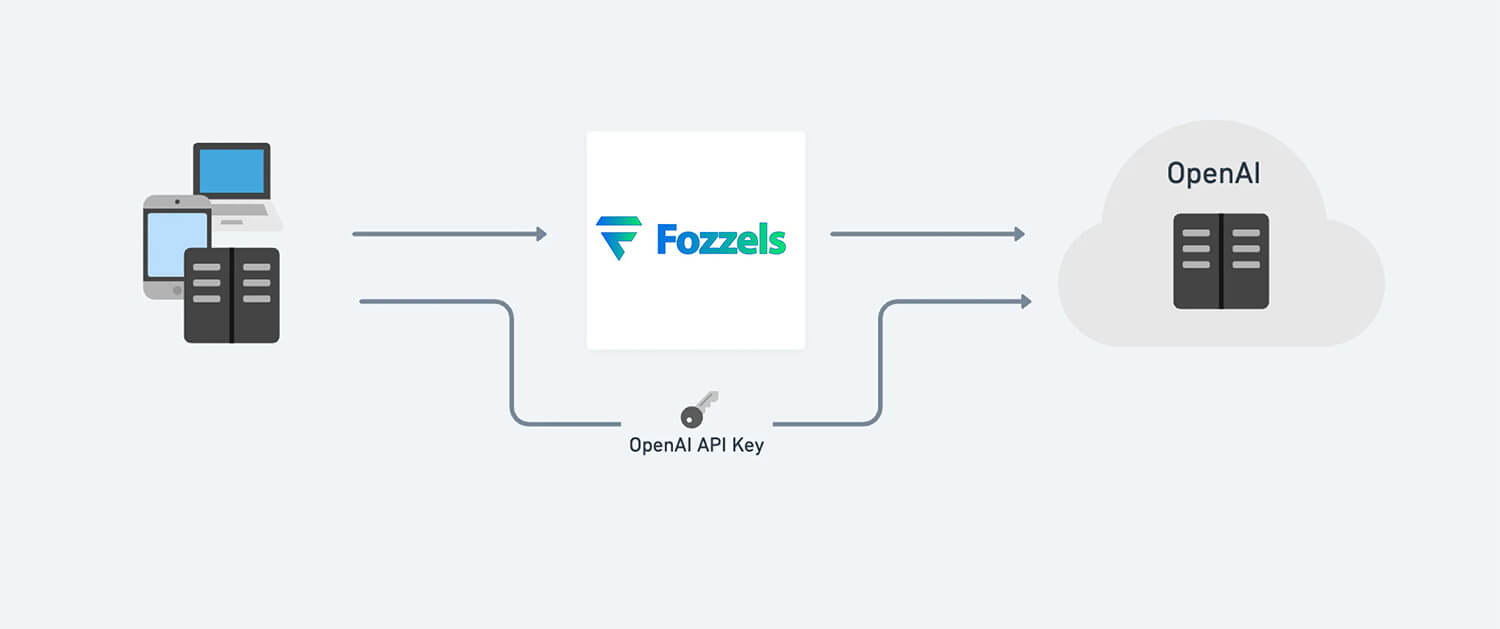

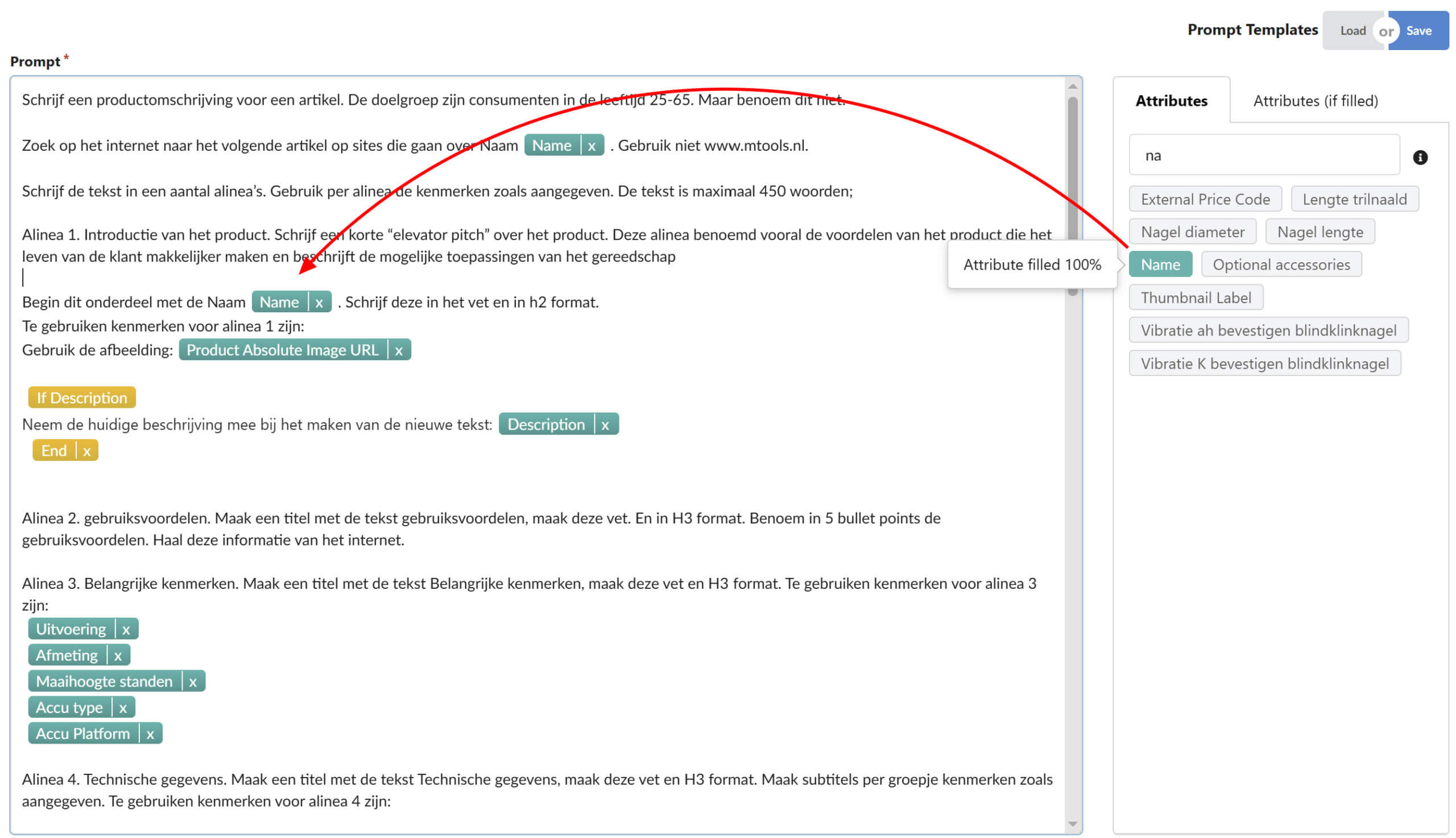

El sistema Fozzels.com obtiene sus datos de los sistemas GPT-3 y GPT-4 de OpenAI. Esto se hace a través de su API (interfaz de programación de aplicaciones). Como cliente de Fozzels, deberá vincular su propia cuenta OpenAI y deberá pagar a OpenAI por separado por los textos generados. Fozzels.com es la plataforma en la que puede administrar la generación de textos y automatizar la redacción de contenido para su tienda en línea.

Tabla de contenido

OpenAI ofrece múltiples modelos de lenguaje, cada uno con diferentes capacidades y precios. Ada es el modelo más rápido, mientras que Da Vinci Es el más poderoso.

Los precios que se muestran en la tabla son por cada 1000 tokens. Puedes pensar en los tokens como si fueran fragmentos de palabras, donde 1000 tokens equivalen aproximadamente a 750 palabras.

| Modelo | Capacitación | Uso |

| Ada | $0.0004 / 1000 tokens | $0.0016 / 1000 tokens |

| Babbage | $0.0006 / 1000 tokens | $0.0024 / 1000 fichas |

| Curie | $0.0030 / 1000 tokens | $0.0120 / 1000 tokens |

| Da Vinci | $0.0300 / 1000 tokens | $0.1200 / 1000 tokens |

¿Qué costos esperar por usar ChatGPT?

Para tener una idea de los costos de generar automáticamente textos de descripción de productos para su tienda en línea utilizando Fozzels.com, vea la tabla a continuación.

A modo de ejemplo: 1000 textos de descripción de productos, con 100 palabras cada uno, generado por el motor ChatGPT “Davinci”, cuesta alrededor de $2,66.

| Modelo | Nota | Precio | Fichas PR | Es ~ palabras | Costos por palabra | Costos por texto de 100 palabras | 1000 textos de productos de 100 palabras generados |

|---|---|---|---|---|---|---|---|

| Ada | Lo más rápido | $0.000400 | 1000 | 750 | $0.000000533 | $0.000053333 | $0.053333333 |

| Babbage | $0.000500 | 1000 | 750 | $0.000000667 | $0.000066667 | $0.066666667 | |

| Curie | $0.002000 | 1000 | 750 | $0.000002667 | $0.000266667 | $0.266666667 | |

| Da Vinci | El más poderoso | $0.020000 | 1000 | 750 | $0.000026667 | $0.002666667 | $2.666666667 |

¿Qué es un token?

Los tokens se pueden considerar como fragmentos de palabras que se utilizan para el procesamiento del lenguaje natural. En el caso de un texto en inglés, un token equivale aproximadamente a 4 caracteres o 0,75 palabras. Como punto de referencia, las obras completas de Shakespeare suman alrededor de 900 000 palabras o 1,2 millones de tokens.

Para obtener más información sobre cómo funcionan los tokens y estimar su uso: a) Experimente con la herramienta interactiva OpenAI. Herramienta tokenizadora; o b) inicie sesión en su cuenta OpenAI e ingrese texto en Playground. El contador en el pie de página mostrará cuántos tokens hay en su texto.

¿Qué modelo debo utilizar?

Si bien Davinci es, en general, el modelo más capaz, los demás modelos pueden realizar determinadas tareas de manera excelente y, en algunos casos, considerablemente más rápido. También tienen ventajas en términos de costo. Por ejemplo, Curie puede realizar muchas de las mismas tareas que Davinci, pero más rápido y por una décima parte del costo. Alentamos a nuestros clientes a experimentar para encontrar el modelo que sea más eficiente para su aplicación. Visite la documentación de OpenAI para obtener información más detallada. Comparación de modelos.

Los modelos GPT-3 de OpenAI pueden comprender y generar lenguaje natural. OpenAI ofrece cuatro modelos principales con diferentes niveles de potencia adecuados para distintas tareas. Davinci es el modelo más capaz y Ada es el más rápido. Si bien Davinci es generalmente el más capaz, los otros modelos pueden realizar ciertas tareas extremadamente bien con ventajas significativas en cuanto a velocidad o costo. Recomendamos usar Davinci mientras experimenta, ya que obtendrá los mejores resultados. Una vez que todo funcione, le recomendamos que pruebe los otros modelos para ver si puede obtener los mismos resultados con una latencia menor.

Da Vinci

El modelo GPT-3 más capaz. Puede realizar cualquier tarea que los otros modelos puedan realizar, a menudo con mayor calidad, salida más larga y mejor seguimiento de instrucciones. También admite la inserción de terminaciones dentro del texto. Davinci es la familia de modelos más capaz y puede realizar cualquier tarea que los otros modelos puedan realizar y, a menudo, con menos instrucciones. Para aplicaciones que requieren una gran comprensión del contenido, como resúmenes para una audiencia específica y generación de contenido creativo, Davinci producirá los mejores resultados. Estas mayores capacidades requieren más recursos informáticos, por lo que Davinci cuesta más por llamada API y no es tan rápido como los otros modelos. Otra área en la que Davinci brilla es en Entendiendo la intención del textoDavinci es bastante bueno para resolver muchos tipos de problemas de lógica y explicar los motivos de los personajes. Davinci ha podido resolver algunos de los problemas de IA más desafiantes que involucran causa y efecto. Es bueno en: intención compleja, causa y efecto, resumen para la audiencia.

Curie

Curie es extremadamente potente, pero muy rápido. Si bien Davinci es más fuerte cuando se trata de analizar textos complejos, Curie es bastante capaz para muchas tareas matizadas como la clasificación y el resumen de sentimientos. Curie también es bastante bueno para responder preguntas y realizar preguntas y respuestas y como un chatbot de servicio general. Bueno en: traducción de idiomas, clasificación compleja, sentimientos de texto, resumen

Babbage

Babbage puede realizar tareas sencillas, como una clasificación simple. También es muy capaz en lo que respecta a la clasificación de búsqueda semántica, ya que permite saber qué tan bien coinciden los documentos con las consultas de búsqueda. Es bueno en: clasificación moderada, clasificación de búsqueda semántica

Ada

Ada suele ser el modelo más rápido y puede realizar tareas como analizar texto, corregir direcciones y ciertos tipos de tareas de clasificación que no requieren demasiados matices. El rendimiento de Ada a menudo se puede mejorar proporcionando más contexto. Es bueno en: analizar texto, clasificación simple, corrección de direcciones, palabras clave. Nota: Cualquier tarea realizada por un modelo más rápido como Ada puede ser realizada por un modelo más potente como Curie o DaVinci.