Dostępne są zaktualizowane informacje

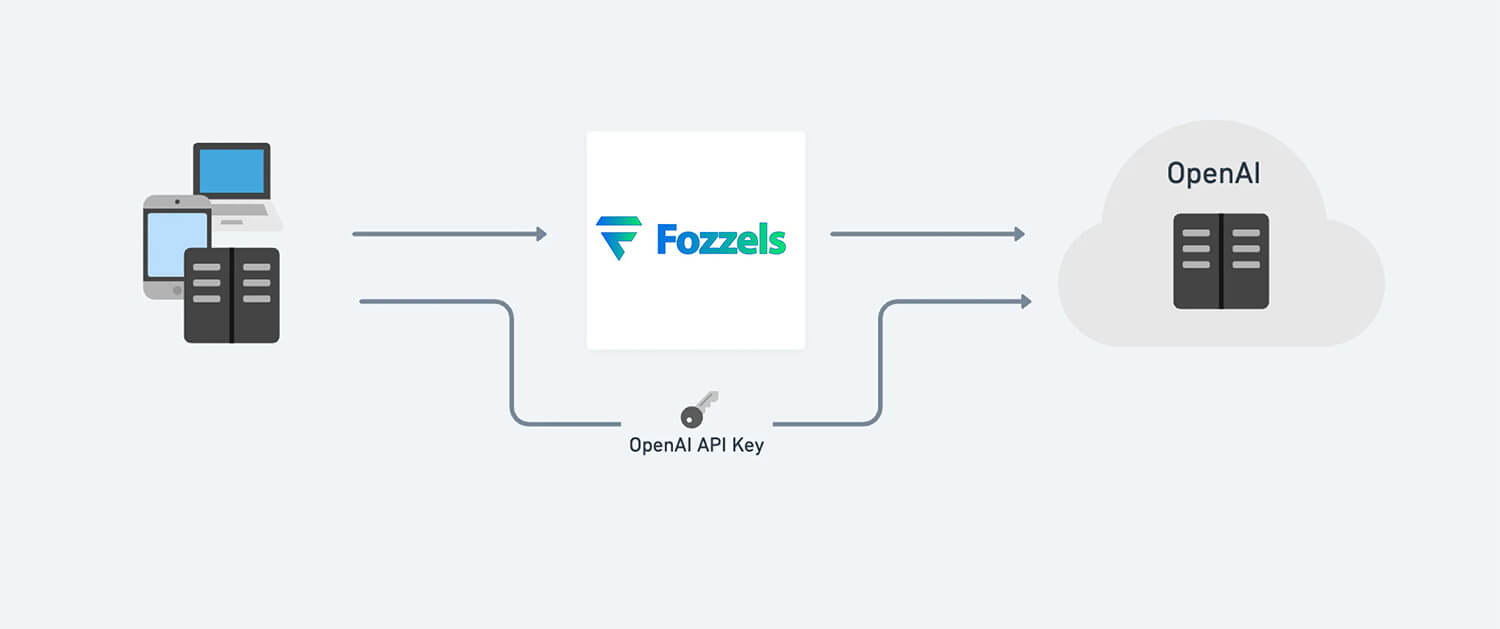

The Fozzels.com system gets its data from the GPT-3 and GPT-4 systems at OpenAI. This is done through their API (application programming interface). As a customer of Fozzels, you will need to link your own OpenAI-account, and you will need to pay OpenAI separately for the texts that are generated. Fozzels.com is the platform where you can manage your text generations, and automate the content writing for your online store.

Spis treści

OpenAI oferuje wiele język modeli, każdy o różnych możliwościach i cenie. Ada jest najszybszym modelem, podczas gdy Davinci jest najpotężniejszy.

Ceny podane w tabeli są za 1000 tokenów. Możesz myśleć o tokenach jako o fragmentach słów, gdzie 1000 tokenów to około 750 słów.

| Model | Szkolenie | Stosowanie |

| Ada | $0.0004 / 1000 tokenów | $0.0016 / 1000 tokenów |

| Babbage | $0.0006 / 1000 tokenów | $0.0024 / 1000 tokenów |

| Curie | $0.0030 / 1000 tokenów | $0.0120 / 1000 tokenów |

| Davinci | $0.0300 / 1000 tokenów | $0.1200 / 1000 tokenów |

Jakich kosztów należy się spodziewać korzystając z ChatGPT

Aby uzyskać informacje o kosztach automatycznego generowania tekstów opisów produktów dla Twojego sklepu internetowego, pl.fozzels.comzobacz poniższą tabelę.

Na przykład: 1000 tekstów opisowych produktów, z 100 słów każde, wygenerowane przez silnik ChatGPT „Davinci”, będzie koszt około $2,66.

| Model | Notatka | Cena | Tokeny Pr | Jest ~ słowa | Koszty za słowo | Koszty za tekst 100 słów | Wygenerowano 1000 tekstów produktów składających się z 100 słów |

|---|---|---|---|---|---|---|---|

| Ada | Najszybszy | $0.000400 | 1000 | 750 | $0.000000533 | $0.000053333 | $0.053333333 |

| Babbage | $0.000500 | 1000 | 750 | $0.000000667 | $0.000066667 | $0.066666667 | |

| Curie | $0.002000 | 1000 | 750 | $0.000002667 | $0.000266667 | $0.266666667 | |

| Davinci | Najpotężniejszy | $0.020000 | 1000 | 750 | $0.000026667 | $0.002666667 | $2.666666667 |

Czym jest token?

Możesz myśleć o tokenach jako o fragmentach słów używanych do przetwarzania języka naturalnego. W przypadku tekstu angielskiego 1 token to około 4 znaki lub 0,75 słowa. Jako punkt odniesienia, zebrane dzieła Szekspira mają około 900 000 słów lub 1,2 mln tokenów.

Aby dowiedzieć się więcej o działaniu tokenów i oszacować ich wykorzystanie: a) Eksperymentuj z interaktywnym narzędziem OpenAI Narzędzie Tokenizer; lub b) zaloguj się na swoje konto OpenAI i wprowadź tekst do Playground. Licznik w stopce wyświetli liczbę tokenów w Twoim tekście.

Którego modelu powinienem użyć?

Podczas gdy Davinci jest ogólnie najbardziej wydajnym modelem, inne modele mogą wykonywać pewne zadania wyjątkowo dobrze, a w niektórych przypadkach znacznie szybciej. Mają też przewagę kosztową. Na przykład Curie może wykonywać wiele takich samych zadań jak Davinci, ale szybciej i za 1/10 ceny. Zachęcamy naszych klientów do eksperymentowania, aby znaleźć model, który jest najbardziej wydajny dla Twojej aplikacji. Odwiedź dokumentację OpenAI, aby uzyskać bardziej szczegółowe informacje porównanie modeli.

Modele GPT-3 OpenAI potrafią rozumieć i generować język naturalny. OpenAI oferuje cztery główne modele o różnych poziomach mocy, odpowiednie do różnych zadań. Davinci jest najbardziej wydajnym modelem, a Ada jest najszybsza. Podczas gdy Davinci jest ogólnie najbardziej wydajny, inne modele mogą wykonywać pewne zadania wyjątkowo dobrze, przy znacznych korzyściach w zakresie szybkości lub kosztów. Zalecamy korzystanie z Davinci podczas eksperymentów, ponieważ da najlepsze rezultaty. Gdy wszystko zacznie działać, zachęcamy do wypróbowania innych modeli, aby sprawdzić, czy można uzyskać takie same rezultaty przy niższym opóźnieniu.

DaVinci

Najbardziej wydajny model GPT-3. Może wykonywać dowolne zadanie, które mogą wykonywać inne modele, często z wyższą jakością, dłuższym wyjściem i lepszym przestrzeganiem instrukcji. Obsługuje również wstawianie uzupełnień w tekście. Davinci jest najbardziej wydajną rodziną modeli i może wykonywać dowolne zadanie, które mogą wykonywać inne modele, często z mniejszą liczbą instrukcji. W przypadku aplikacji wymagających dużego zrozumienia treści, takich jak podsumowanie dla określonej grupy odbiorców i generowanie kreatywnych treści, Davinci zapewni najlepsze wyniki. Te zwiększone możliwości wymagają więcej zasobów obliczeniowych, więc Davinci kosztuje więcej na wywołanie API i nie jest tak szybki jak inne modele. Innym obszarem, w którym Davinci się wyróżnia, jest zrozumienie intencji tekstu. Davinci jest całkiem dobry w rozwiązywaniu wielu rodzajów problemów logicznych i wyjaśnianiu motywów postaci. Davinci był w stanie rozwiązać niektóre z najtrudniejszych problemów AI związanych z przyczyną i skutkiem. Dobry w: złożonych intencjach, przyczynach i skutkach, podsumowaniu dla odbiorców.

Curie

Curie is extremely powerful, yet very fast. While Davinci is stronger when it comes to analyzing complicated text, Curie is quite capable for many nuanced tasks like sentiment classification and summarization. Curie is also quite good at answering questions and performing Q&A and as a general service chatbot. Good at: Language translation, complex classification, text sentiment, summarization

Babbage

Babbage może wykonywać proste zadania, takie jak prosta klasyfikacja. Jest również całkiem zdolny, jeśli chodzi o ranking wyszukiwania semantycznego, jak dobrze dokumenty pasują do zapytań wyszukiwania. Dobry w: Umiarkowanej klasyfikacji, klasyfikacji wyszukiwania semantycznego

Ada

Ada jest zazwyczaj najszybszym modelem i może wykonywać zadania takie jak parsowanie tekstu, korekta adresów i pewne rodzaje zadań klasyfikacyjnych, które nie wymagają zbyt wielu niuansów. Wydajność Ady można często poprawić, zapewniając więcej kontekstu. Dobry w: parsowaniu tekstu, prostej klasyfikacji, korekcie adresów, słowach kluczowych. Uwaga: Każde zadanie wykonywane przez szybszy model, taki jak Ada, może zostać wykonane przez mocniejszy model, taki jak Curie lub Davinci.